¿Qué mejor manera de comenzar esta serie de artículos sobre inteligencia artificial que hablando de algo que casi nadie se para a pensar con detenimiento? La seguridad.

Estamos experimentando la forma en que la inteligencia artificial se integra cada vez más en nuestra vida diaria y profesional. La usamos para automatizar tareas, para generar ideas, para resolver problemas… y lo hacemos con total naturalidad. Pero la verdad es que probar una automatización o, empezar a interactuar con un agente de IA es tan sencillo, que apenas requiere conocimientos técnicos.

La inmediatez de esta tecnología es una de las mayores virtudes que tiene la inteligencia artificial, pero también uno de sus mayores peligros porque no nos permite reflexionar sobre los riesgos que puede haber detrás de cada herramienta.

La inmediatez de esta tecnología es una de las mayores virtudes que tiene la inteligencia artificial, pero también uno de sus mayores peligros porque no nos permite reflexionar sobre los riesgos que puede haber detrás de cada herramienta.

La entrada en escena de modelos de lenguaje como Chat GPT, es una puerta abierta a este tipo de ataques. Estos sistemas traen nuevos riesgos, como la manipulación mediante prompt injection o el uso inseguro de sus respuestas. Igualmente, amplifican problemas tradicionales, como la exposición de claves o la ejecución de código indirecto.

El artículo publicado por OWASP, la comunidad de referencia en ciberseguridad, indica que estos ataques pueden derivar en acceso no autorizado, filtrado de datos y ejecución no deseada. Por esta razón, también han surgido catálogos específicos como MITRE ATLAS que recopilan técnicas y casos reales de ataques, como envenenamiento de datos o extracción de modelos, acompañadas de medidas de mitigación. Este tipo de recursos son importantes para anticipar y mapear las amenazas específicas que pueden surgir contra sistemas de automatización de inteligencia artificial.

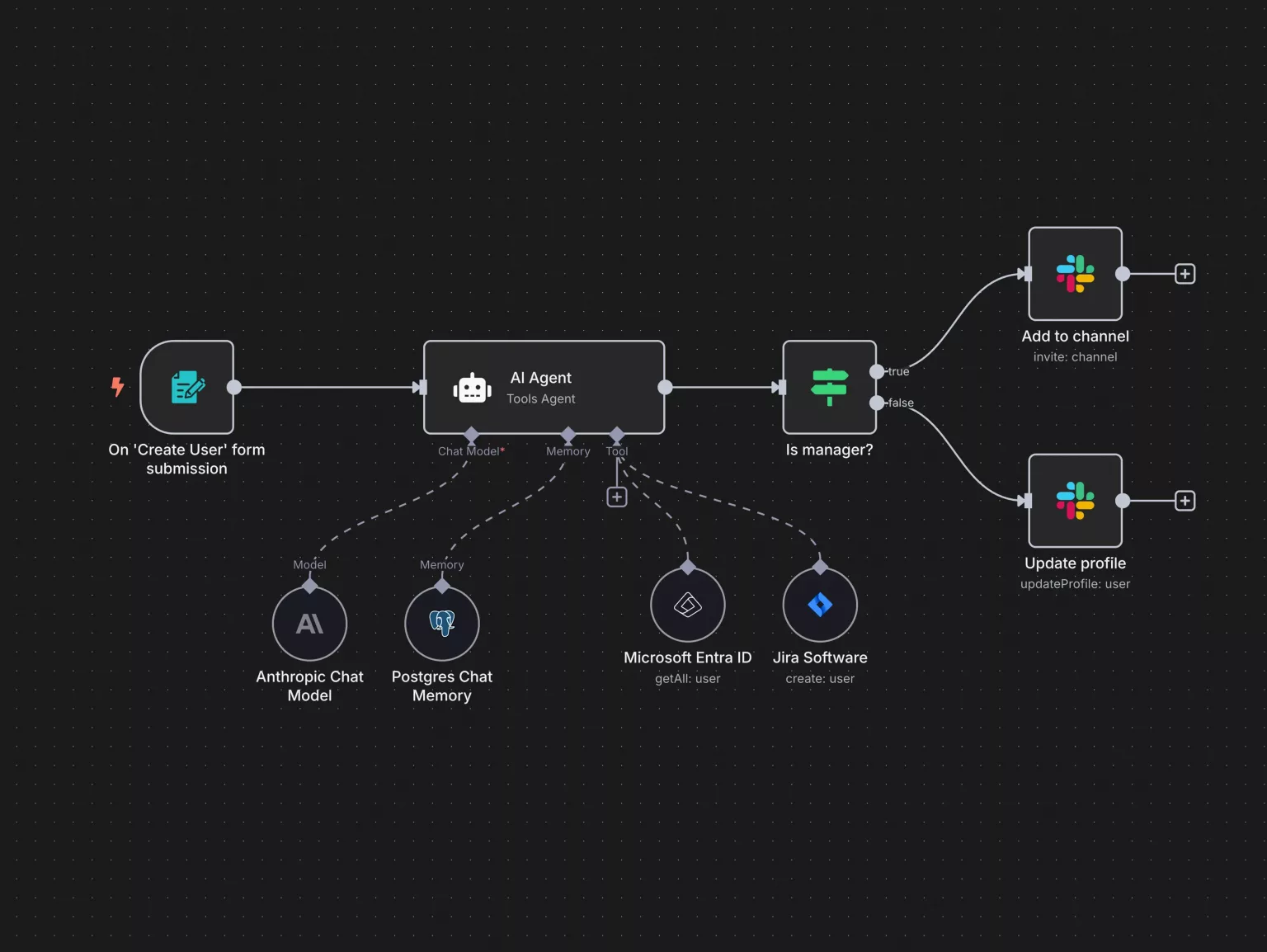

La IA ha desarrollado un papel protagonista en mejorar las capacidades de la automatización. Al contar con ella en muchos sistemas, las empresas dejan atrás procesos rígidos basados en reglas para adoptar flujos de trabajo dinámicos e inteligentes. Y es que esto no solo ejecuta tareas, sino que optimiza la asignación de recursos en tiempo real, respondiendo a eventos imprevistos sin depender de procedimientos predefinidos, lo que reduce el trabajo manual y acelera el lanzamiento de nuevas soluciones al mercado.

Sin embargo, la fiebre por automatizar con n8n y “agentes” de IA ha disparado la creatividad… y también la superficie de ataque. Estas herramientas reaccionan a toda la información que reciben, invitando así a los hackers, que aprovechan cualquier imprevisto para implementar información fraudulenta.

Lo preocupante es que son fallos básicos de ciberseguridad, como poner tus API keys en archivos, aceptar datos sin verificar su origen, claves anónimas de bases de datos, o compartir servidores.

Estos son los riesgos reales y los marcos que deberías seguir para que tus flujos no solo funcionen, sino que resistan.

Las automatizaciones de IA pueden ser un gran impulso para la productividad, pero también representan un punto de entrada atractivo para atacantes si no se gestionan con cuidado. La clave no está en complicar los procesos, sino en incorporar medidas de seguridad efectivas desde el principio.

Entre otras, la segmentación de entornos para evitar accesos innecesarios, la actualización constante de conectores, y el monitoreo de registros para detectar comportamientos anómalos en tiempo real. Con estos pasos, es posible aprovechar la agilidad de la inteligencia artificial sin sacrificar la protección de los sistemas ni de los datos.

Pero si de verdad quieres proteger tus flujos, el primer paso es formarte en inteligencia artificial.

Bienvenido al

Bienvenido al

Bienvenido al

Bienvenido al

Bienvenido al

Bienvenido al

Bienvenido al

Bienvenido al